UX評価に「感情の変化」を活かす。臨床グレードの感情認識AIソフトウェアとは

- 事例

UI/UX開発、スマートデバイス、XR体験、車載HMI、メディア評価など、ユーザーの“状態”を可視化するニーズが高まる中、次々に変化するユーザーの感情状態や反応をリアルタイムに把握する技術が注目されています。

英国発のBLUESKEYE AI社は、表情からユーザーの感情を高精度に認識・測定する独自の技術を開発し、多様な業界での活用が広がっています。本記事では、同社の技術の背景と特徴、導入事例、実装性に焦点を当ててご紹介します。

英国発、臨床グレードの感情認識AI技術

BLUESKEYE AI社は、2019年にノッティンガム大学からスピンアウトし設立されました。創業者は、感情認識研究の第一人者であるミシェル・ヴァルスター教授ら3名で、彼の研究は17,000回以上の引用実績を誇ります。2022年には約6億円の資金調達にも成功し、社員の3分の1が博士号を持つ高度な技術チームが開発を牽引しています。

この技術は、ヘルスケアや福祉、コンシューマ製品、ロボット、自動車など多様な分野で活用が進んでいます。臨床グレードの安全性を確保するため、ISO 27001(ISMS)を取得しており、安心して評価・導入が可能です。

回り込み回避(公開ページにはこのパーツ表示されません)

感情の“動き”を可視化する

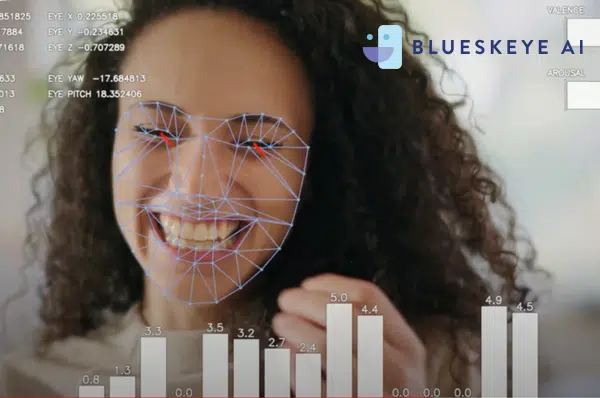

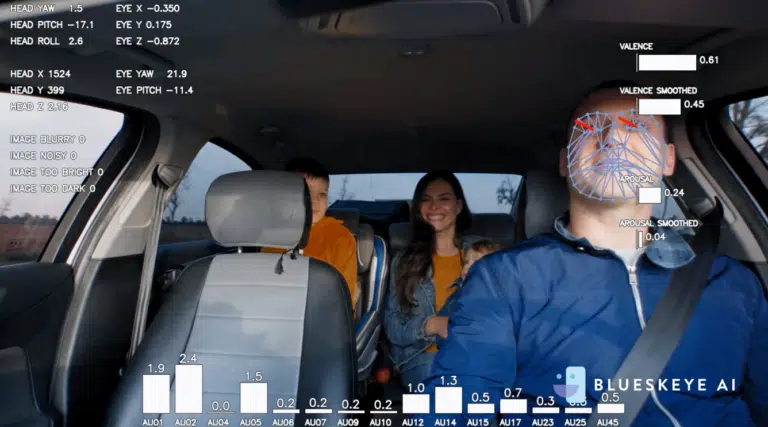

BLUESKEYE AIのコア技術は、視線・表情トラッキングや表情筋の動きの検出を通じて、「感情(valence)」と「覚醒(arousal)」をリアルタイムで数値化するものです。例えば、広告やARコンテンツへの反応、疲労感やストレスといった心理状態の変化を、時間軸に沿って測定・分析できます。

特徴的なのは、感情を“分類”ではなく“連続的な変化”として捉える点です。人の本来の感情の動きをより正確に反映できるため、UX評価やユーザー状態のモニタリングに高い解像度で応用できます。

回り込み回避(公開ページにはこのパーツ表示されません)

カメラ映像からの高精度な感情推定

BLUESKEYE AIは、表情、視線、頭部姿勢など複数のパラメータをリアルタイムに解析し、「楽しい」「悲しい」「興奮」「退屈」「イライラ」「集中」などの感情状態を推定する独自のAIエンジンを搭載しています。

以下のような高度な解析が可能です:

- 視線のトラッキング:どこを見ているかを高精度で推定

- 表情筋の解析:ごく短時間の微細な表情の変化も検出

- 視線+表情+頭の位置などの統合認識:より正確な感情判断へと昇華

さらに、推定結果をタイムライン形式で出力することができ、動画コンテンツや体験コンテンツの“どの場面で反応が良かったか”をデータで可視化できます。

回り込み回避(公開ページにはこのパーツ表示されません)

軽量・端末処理型SDKで組み込みやすい設計

BLUESKEYE AIの技術は、ソフトウェア開発キット(SDK)として提供されており、全て端末内処理で動作するため、プライバシーを保ったまま運用可能です。軽量でありながら、高度な感情推定をリアルタイムで実行でき、デスクトップ・モバイル問わずさまざまなOS環境に導入できます。

また、産業用や自動車用途などの低出力環境にも対応しており、一般的なRGBカメラのほか、近赤外線カメラによる暗所対応も可能です。ソフトウェアのみの構成で機能追加や更新も容易なため、プロトタイピングから製品組み込みまでスムーズに行えます。通常のWebカメラ等で取得した映像からこのような解析が行えることから、特別なセンサや高価な装置を必要としない点が大きな特長です。

事例:妊産婦向けアプリ「Avocado」

技術の社会実装事例としては、イギリスでリリースされた妊婦向けアプリ「Avocado」があります。ユーザーが日々の表情や声を記録することで、妊娠中や産後の気分の変化を自動で評価し、セルフケアに役立てることができます。このアプリはこれまでに25万人以上に利用され、1カ月あたり1万人のアクティブユーザーを獲得しています。

回り込み回避(公開ページにはこのパーツ表示されません)

デモ動画で見るリアルな感情の変化

実際の映像では、清涼飲料水のブラインドテストの様子や運転中のドライバー状態などをリアルタイムに可視化する様子をご覧いただけます。UX評価や体験設計、製品改善などにおける定量的指標としても活用が期待されます。

回り込み回避(公開ページにはこのパーツ表示されません)

この記事の監修者

コーンズテクノロジー編集部

コーンズテクノロジーでは先進的な製品・技術を日本産業界へ紹介する技術専門商社として、通信計測・自動車・防衛セキュリティ・電子機器装置・航空宇宙・産業機械といった技術分野のお役立ち情報を紹介しています。